GPU son las siglas de "Graphics Processing Unit", término con el que se denomina técnicamente a las tarjetas gráficas. Utilizar el potencial de supercomputación con el que cuenta la GPU para resolver cálculos ha supuesto una revolución en los ámbitos científico y empresarial, pudiendo resolver problemas complejos en mucho menor tiempo.

GPU son las siglas de "Graphics Processing Unit", término con el que se denomina técnicamente a las tarjetas gráficas. Utilizar el potencial de supercomputación con el que cuenta la GPU para resolver cálculos ha supuesto una revolución en los ámbitos científico y empresarial, pudiendo resolver problemas complejos en mucho menor tiempo.

En 2010 CETA-Ciemat fue un centro pionero al hacer una fuerte inversión en computación GPGPU (General Purpose Graphics Processing Unit – Unidad de procesamiento gráfico de propósito general). Si una sola GPU ya ofrece un potencial increíble, un cluster equipado con esta tecnología abre incluso la puerta a problemas científicos que antes no era posible plantear resolverlos.

A mediados de 2012, CETA-Ciemat ha sido reconocida como GPU Research Center, mención otorgada a aquellos centros cuyas investigaciones en el ámbito de las GPUs son relevantes a nivel mundial. Actualmente sólo existen 4 GPU Research Centers en España y unos 70 en todo el mundo.

El cluster de GPUs está abierto a los usuarios y actualmente es utilizado por investigadores de más de 40 grupos e instituciones de investigación de todo el mundo. Estos investigadores utilizan el cluster con diferentes propósitos, donde el CETA provee soporte CUDA, soporte con el envío y paralelización de trabajos. Entre estos proyectos destacan los siguientes:

- Dinámica molecular, utilizando especialmente GROMACS & LAMMPS, para descubrimiento de nuevos fármacos (entre otras aplicaciones)

- Procesamiento de imágenes, llevando a cabo procesamiento en tiempo real de imágenes hiperespectrales, para ayudar en la detección de diferentes tipos de objetivos como agentes contaminantes en agua y aire, detección de incendios, etc.

- Análisis numérico y resolución de sistemas de ecuaciones lineales, acelerando los cálculos de forma notable.

- Imagen médica, procesando imágenes de resonancia magnética para llevar a cabo diferentes estudios enfocados a facilitar el diagnóstico de enfermedades como el cáncer de mama o tumores cerebrales.

- Secuenciación genómica, para acelerar los complejos cálculos de análisis de las secuencias.

- Astrofísica y simulación espacial, en proyectos financiados por la Agencia Espacial Europea

- Fusión nuclear, acelerando los cálculos de predicción en la evolución de defectos en materiales irradiados

- Visión por ordenador, para el desarrollo de algoritmos eficientes que permitan calcular la compensación de la distorsión visual.

- Sistemas de información geográfica (SIG), dando soporte al desarrollo de Grass GIS como herramienta de código abierto, utilizando el procesamiento con GPUs para acelerar el procesamiento de mapas e imágenes.

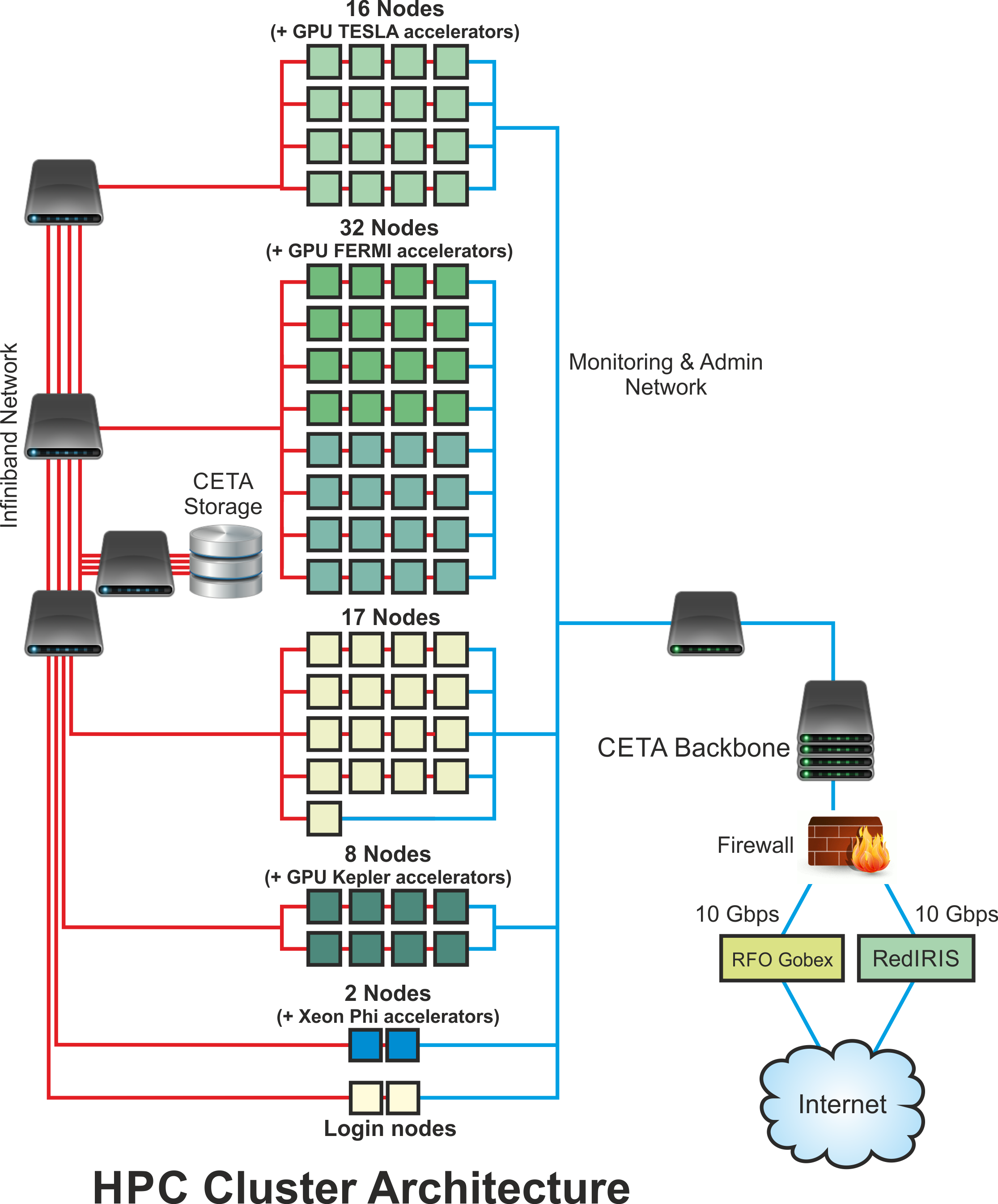

Cuando un usuario se conecta al sistema a través del nodo de acceso a la infraestructura HPC, puede enviar trabajos desde su carpeta de usuario a cualquiera de los recursos disponibles para todo el entorno de trabajo de supercomputación. De esta forma se facilita a los usuarios la posibilidad de evaluar diferentes plataformas de supercomputación.

El gestor de recursos utilizado es SLURM (Simple Linux Utility for Resource Management), el cual siendo totalmente libre y de código abierto, es uno de los más utilizados en supercomputadores más potentes del mundo.

Total

100.000 cores GPU aproximadamente, desglosados en:

- 1 nodo de login R425E2 con TESLA K20 (1 K20 por nodo)

- 22 nodos R422E2 con TESLA S1070 (2 C1060 por nodo)

- 16 nodos R422E2 con TESLA S2050 (2 C2050 por nodo)

- 16 nodos R424E2 con TESLA S2070 (2 M2075 por nodo)

- 8 nodos R421E3 con TESLA K80 (1 K80 por nodo)

Procesador

- R422E2/R423E2: 2 x Quad Core Intel® Xeon E5520 @ 2.27GHz

- R424E2: 2 x Quad Core Intel® Xeon® E5649 @ 2.53GHz

- R425E2: 2 x Quad Core Intel® Xeon® X5570 @ 2.93GHz

- R421E3: 2 x 12-Core Intel® Xeon E5-2680v3 @ 2.5GHz

Memoria

- R422E2/R423E2/R424E2: 24 GBytes DDR3

- R425E2: 96 GBytes DDR3

- R421E3: 64 GBytes DDR4

GPUs

- Entorno Test: 2 x C1060 por nodo (S1070)

- Entorno Producción:

- 2 x C2050 por nodo (S2050)

- 2 x M2075 por nodo (S2070)

- 1 x K20 por nodo

- 1 x K80 por nodo (S2070)

Sistema operativo

- CentOS 7.3

Almacenamiento

- Interno

- SATA 500 GB

- Compartido

Conectividad

- Infiniband QDR (40 Gbps)

- 2 Ethernet (1 Gbps)

- Infiniband QDR/FDR (40/56 Gbps)